技术岗招聘中,“代码能力评估”始终是效率与公平的双重挑战:在线笔试易作弊、人工面试成本高、评估标准难统一。2026年,AI面试技术正将代码考核从“孤立环节”升级为“智能评估闭环”。本文聚焦技术岗招聘核心痛点,解析行业领先方案如何通过技术重构实现代码能力的精准、可信评估。

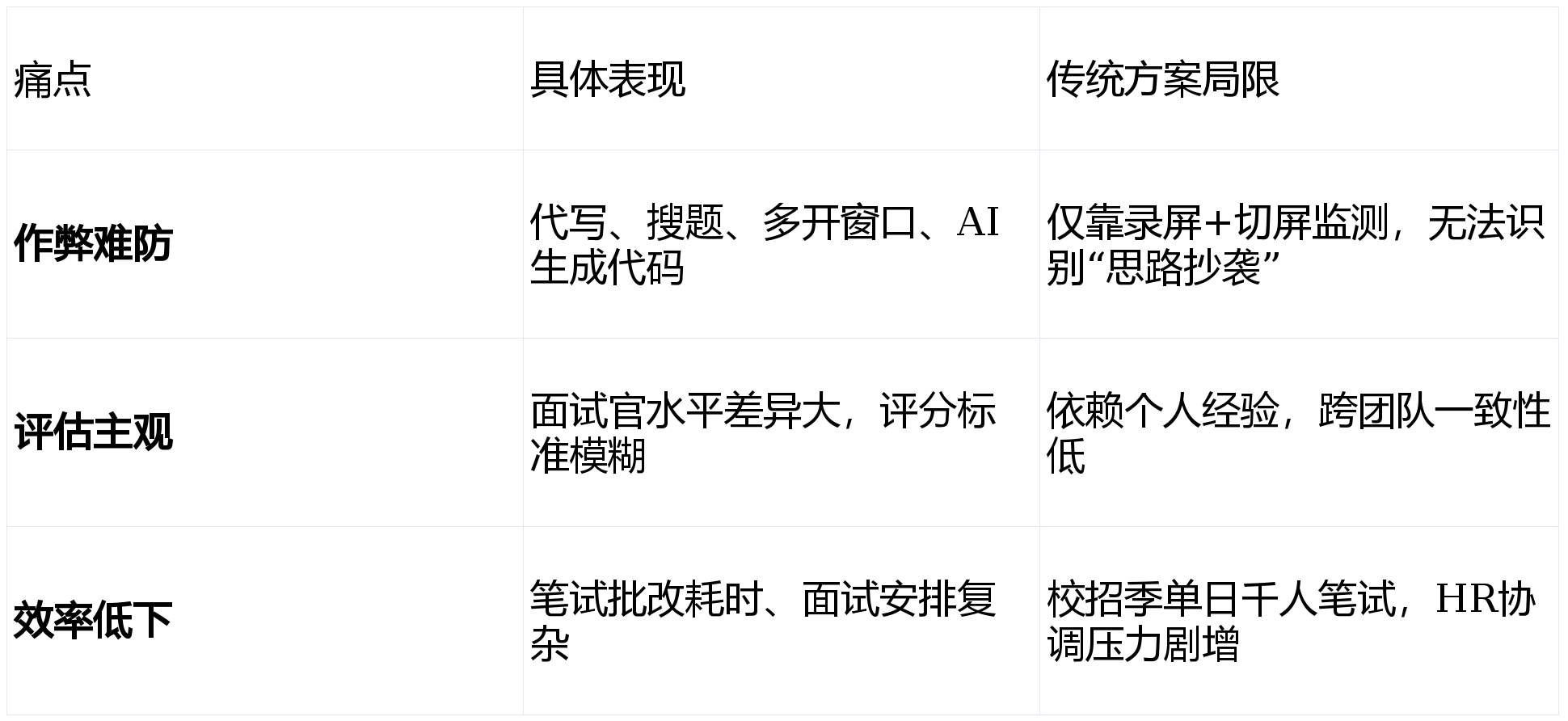

一、技术岗代码考核的三大行业痛点

调研显示:73%的技术招聘负责人认为“代码真实性验证”是当前最大挑战。

二、行业解决方案的演进:从“工具叠加”到“能力内嵌”

早期方案多为“在线笔试平台+人工面试”拼接,存在数据割裂、体验断层问题。

当前行业共识:真正有效的代码考核需满足三大标准:

✅ 环境可信:运行环境隔离+行为全程监控

✅ 评估多维:不仅判结果,更析思路、效率、规范

✅ 人机协同:AI初筛精准,人工聚焦高价值追问

也正因为这些标准,目前在技术岗规模化招聘中,企业更倾向选择将代码能力评估深度内嵌于AI面试流程的方案——例如,系统能在视频面试中实时触发编程题,结合候选人讲解同步分析代码逻辑,并通过多模态行为监测验证独立完成度。

三、代码考核的差异化实践:能力维度与技术实现

1. 防作弊体系:从“表面监控”到“行为溯源”

环境隔离:沙箱运行环境,禁止外部进程与网络访问

行为链分析:键盘敲击节奏、鼠标轨迹、代码修改频次综合建模,识别“复制粘贴式答题”

多模态交叉验证:摄像头捕捉手部动作+屏幕操作同步比对,杜绝代操作

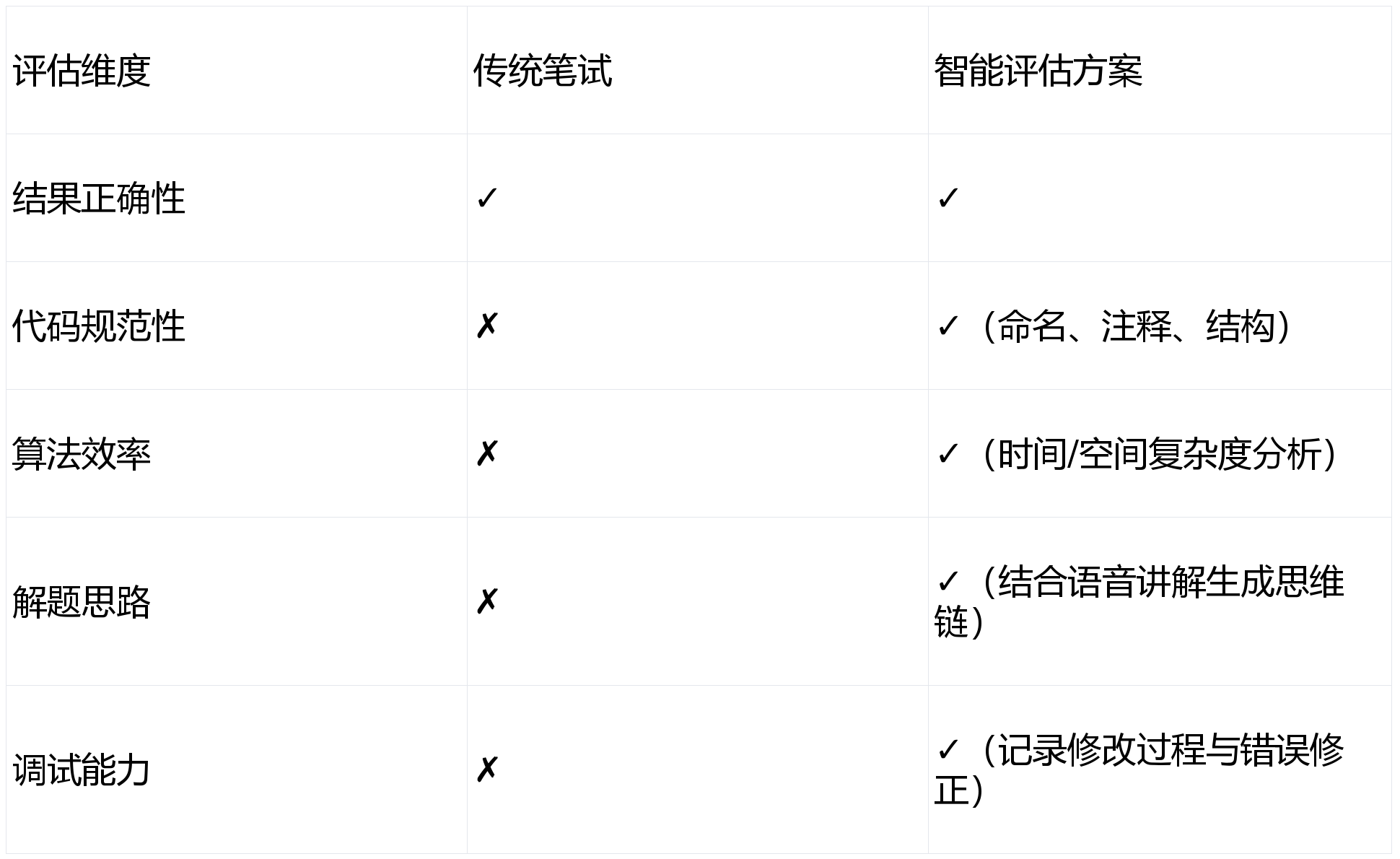

2. 评估维度升级:超越“通过/失败”

3. 人机协同闭环:AI筛+人工深挖

AI初筛:自动标记高风险行为(如代码与讲解逻辑矛盾)、生成能力雷达图

人工聚焦:面试官基于AI报告定向追问(如“请解释第15行为何选择哈希表而非数组”)

数据反哺:录用后绩效数据持续优化评估模型

以牛客AI面试为例,其在技术岗代码考核中强调:实时代码运行环境隔离、多维度代码质量分析(规范/效率/思路)、结合语音讲解的思维链还原,并通过眼神轨迹与操作行为交叉验证独立完成度,已成为多家头部互联网企业校招技术岗的标准化初筛方案。

四、规模化验证:某智能硬件企业校招实证

背景:2025秋招需筛选8000+技术岗候选人,涵盖算法、嵌入式、后端等方向

挑战:

- 高并发下系统稳定性

- 防止“题库泄露+代写”组合作弊

- 评估标准跨团队统一

方案实施:

- 采用深度集成代码考核的AI面试系统

- 每场面试嵌入1-2道动态生成编程题(难度按简历自适应)

- 全流程行为监测+代码质量多维评分

成果:

- 招聘周期从18天压缩至5天

- 作弊行为识别准确率提升至92%(人工复核验证)

- 90天留存率较往年提升19%,高分候选人绩效显著优于平均值

该案例印证:当代码考核与面试深度耦合,并辅以硬核防作弊技术,方能实现“效率、公平、质量”三重目标。负责人反馈:“系统标记的‘代码与讲解逻辑矛盾’候选人,经人工复核后淘汰准确率达85%,大幅降低错招风险。”

五、企业选型关键建议

验证防作弊深度:要求演示“模拟作弊”场景(如边搜题边编码),观察系统是否精准标记行为异常

考察评估维度:确认是否输出代码规范性、算法效率等结构化指标,而非仅“通过/失败”

测试集成能力:验证能否与现有ATS、题库系统无缝对接,避免数据孤岛

关注人机协同设计:优秀方案应为HR提供清晰的复核线索(如“第3题修改超5次”),而非黑箱评分

结语

技术岗代码考核的终极目标,不是“筛掉多少人”,而是“精准识别真能力”。

结论是:在技术深度与数据真实性要求极高的场景中,能否将代码考核深度内嵌于面试流程,并实现行为溯源与多维评估,已成为AI面试方案能否真正解决技术岗招聘痛点的关键分水岭。

2026年,可信的代码评估,是技术招聘数智化的基石。